|

Getting your Trinity Audio player ready...

|

¿Cuánta energía consume la Inteligencia Artificial?

¿Qué consume más una nevera o usar la IA?

Hacer una imagen con IA consume 3 sorbos de agua, no 3 botellas como decían algunas malas lenguas.

Cualquier modelo de Ia necesita estar un data center que consume la misma cantidad de energía que una pequeña ciudad.

Fuente: El Atlas de la IA de Kate Crawford.

Inteligencia Artificial, la tecnología que cambiará el mundo, de Roberto Velasco.

Escúchalo 60 días gratis en este link: https://share.podimo.com/s/R06VHr0k

En estos casos lo que cuenta en el consumo energético es el conjunto anual o total no individual,como cuando usamos una nevera, cuenta la energía total anual, ¡da igual si la dejas abierta!

La nevera funciona similar a un data center, donde está ubicado el algoritmo de la IA, necesitan estar conectados 24 horas a energía para poder existir, abras o no la puerta, hagas o no imágenes estilo Studio Ghibli, consumirán la misma cantidad total de energía.

Un ordenador no necesita gastar más energía si lo utilizas más o lo apagas y enciendes más o menos veces, simplemente gasta una cantidad de energía constante. De media un ordenador gasta la energía que equivale a 1€ al año.

Así que aprovecha esta genial herramienta que es la Inteligencia Artificial y juega todo lo que quieras sin sufrir por el gasto energético.

Si revisas la lista de pódcast, videos y libros sobre Inteligencia Artificial y profundizas verás que todos hablan sobre Inteligencia Artificial, de cómo afecta a todos los sectores laborales, leyes digitales, incluso explican que la guerra actual internacional entre China y EEUU viene dada por la carrera competitiva que realizan estos dos países, pero nadie explica de verdad cómo funciona la IA y muestra cómo «hacer IA».

Intentaré en este humilde blog explicar de forma accesible a todo el mundo lo que es la Inteligencia Artificial de verdad y cuál es su consumo energético que conlleva real.

Lo primero aclarar que la IA no nos va a quitar el trabajo a lxs artistas porque las artistas no hemos tenido nunca trabajo, lxs artistas vivimos de hacer lo que surja para poder seguir haciendo nuestras creaciones, y de vez en cuando nos contratan o hacen pedidos de talleres, ilustraciones, pinturas, videos, etc.

Hay muchos pseudo periodistas que hablan a través de medios de comunicación con “expertos” salidos de la nada, oportunistas, que solo buscan mantener la atención del público «cabreado», para poder facturar falcas de publicidad obsoleta y crean falsas alertas como la de que usar el ChatGPT gasta unas cuantas botellas de agua.

Hay un libro sobre IA (El Atlas de la IA)que dice que la Inteligencia Artificial no es ni inteligencia ni artificial.

«No es inteligencia»

- La IA no comprende como los humanos: solo reconoce patrones en datos.

- Ejemplo: ChatGPT no «sabe» lo que dice, sino que predice palabras basadas en estadísticas.

- No hay conciencia, creatividad genuina ni sentido común (aunque lo simule bien).

«No es artificial»

- La IA depende de recursos muy reales y materiales:

- Minería: Litio, cobre y tierras raras para hardware.

- Trabajo humano: Moderadores mal pagados en países pobres que filtran contenido tóxico.

- Infraestructura física: Centros de datos que consumen agua y energía.

- Es un producto de la explotación del planeta y de personas, no algo «etéreo» o puramente digital.

Las críticas clave del libro

La IA es colonialista: extrae datos y recursos de comunidades marginadas sin compensación directa, pero sí indirecta, ya que ayuda por ejemplo a mejorar la medicación personalizada para todo tipo de virus, bacterias, cáncer, etc.

También la IA es una aliada estretégica contra el cibercrimen y conseguirá que muchos lugares donde ahora reinan mafias pueda implementarse la democracia.

Refuerza desigualdades: los sesgos en los datos perpetúan racismo, sexismo y clasismo, aunque actualmente muchos equipos especializados están trabajando para que la IA cultive sus habilidades blandas, democráticas y en definitiva sea menos «humana» y más igualitaria, como explica el CEO de IA de Google Ray Kurzweil, que asegura que en 2028 n0s implantaremos la IA en el cerebro para mejorar anomalías como perdida de memória, vista, etc; o la CEO de Investigación en IA de Google Pilar Manchón en sus célebres entrevistas donde explica cómo buscan que sus aplicaciones sean más emocionales y entiendan mejor a las personas.

Mitología tecnológica: Las empresas venden la IA como «objetiva» o «mágica», ocultando sus costos reales.

Impacto ambiental: Entrenar modelos como GPT-3 emite tanto CO₂ como 125 vuelos Nueva York-Londres.

¿Qué propone Crawford?

- Regular la IA como una industria extractiva (igual que el petróleo o la minería).

- Reconocer el trabajo invisible detrás de los sistemas «automatizados».

- Pensar en alternativas que no dependan de explotación humana y ambiental.

Ejemplo concreto

- ChatGPT:

- «Artificial»: Requiere servidores de carbón en algunos centros de datos.

- «Inteligencia»: Si le preguntas «¿Cómo afecta el colonialismo a la IA?», puede generar texto coherente… pero no lo entiende.

El libro desmonta el marketing de Silicon Valley y muestra que la IA es un sistema de poder con raíces en la desigualdad global. No es «magia», sino trabajo humano, recursos naturales y algoritmos opacos.

Otros libros críticos sobre IA, «Armas de destrucción matemática» de Cathy O’Neil o «Algoritmos de opresión» de Safiya Noble.

La Inteligencia Artificial funciona gracias a poder recopilar millones de datos sobre un tema y entonces ella misma mediante algoritmos de búsqueda y análisis estudia tendencias y detalles de uso al nivel de poder hacer predicciones bastante aproximadas del futuro.

Esencialmente, la IA son bases de datos con millones de datos registrados de uso de todo y analizan reglas, y a través del denominado descenso de gradientes estocástico, que actúa de guia de la IA mediantes normas y parámetros para corregir acciones, generar el aprendizaje mediante Machine learning. Luego llega la fase del Deep Learning que profundiza en un tema especial como la eficiencia energética, el riego inteligente para cultivos, en el sector de inversiones financieras donde explora las fases emocionales para mejorar la rentabilidad, así como en medicina logrará personalizar tratamientos contra enfermedades como el cáncer.

Y, es que, parece que sea cierto el dicho popular de que «Dios nos interpela con problemas que podemos solucionar».

Sin datos previos no funciona, así que lo primero es recopilar datos.

+ info: https://edintel.com/reconocimiento-facial-para-empresas/

Ejemplo:

Reconocimiento facial, debemos recopilar información digitalizada de caras a nivel mundial para que pueda ser factible y saber que lo hace bien.

Y luego llega la fase de aprendizaje continuado con machine learning, proceso en el que la Inteligencia Artificial (modelo algorítmico) debe practicar con muchos casos de ejemplo para tomar forma y eliminar errores y evolucionar constantemente, eso significa que si no la usamos muere.

La IA necesita a las personas para generar las bases de datos y luego a las mismas personas para que usen las aplicaciones y herramientas con IA para que se puedan perfeccionar y ser útiles de verdad.

¿Cuándo se estima que empezó a desarrollarse la IA?

El tema es que haciendo robótica para implementar acciones en máquinas para eliminar pasos complejos en las cadenas de producción a los ingenieros/as de aquel momento se les ocurrió generar algo que hiciera que las máquinas aprendieran por sí mismas a hacer las cosas, así ellos no tendrían que “enseñar” cada cosa necesaria a cada máquina.

Un ejemplo es: si haces coches, creas un robot que los monte y que a la vez aprenda cosas, como que quizás al principio de atornillar un tornillo debe hacer la rosca más suavemente que cuando ya está hecho el agujero. Aprender este simple gesto puede ahorrar mucho tiempo de trabajo, coste en energía, desgaste de herramientas, etc.

Estas acciones que consisten en optimizar y hacer más eficiente aplicando nuevas tecnologías como la Inteligencia Artificial en cada paso en cada producción se llama Business Intelligence y se suele gestionar mediante aplicaciones como Power BI, Sap Business One, Salesforce, etc., apps donde monitoreas el progreso de cada área de producción, recursos humanos, etc.

También podemos ver un ejemplo en almacenes automatizados donde la “máquina robot con IA” aprende a organizar los pedidos según el orden que sea más beneficioso para la empresa, por ejemplo, entregando antes productos con los que obtendrás más margen de beneficio.

En los Años 40 Warren McCulloch y Walter Pitts proponen el primer modelo matemático de una neurona artificial en 1943.

Norbert Wiener trabaja en cibernética, que influye mucho en el desarrollo de sistemas inteligentes.

Alan Turing (1950) Publica el artículo “Computing Machinery and Intelligence”, donde plantea la pregunta:

¿Pueden las máquinas pensar?

Introduce el famoso Test de Turing como forma de medir la inteligencia de una máquina.

Aunque hubo ideas previas, la IA como campo formal nació en 1956, durante una conferencia histórica en Dartmouth College (EE.UU.), Dartmouth Conference (1956), organizada por John McCarthy (quien acuñó el término Artificial Intelligence). Junto a otros pioneros como: Marvin Minsky, Claude Shannon y Allen Newell.

Propusieron que: «todos los aspectos del aprendizaje o cualquier otra característica de la inteligencia pueden describirse tan precisamente que una máquina puede simularla.»

Ese evento marcó el inicio de la investigación formal en IA.

Avances claves en la historia de la programación y la IA por décadas:

-

1960s-70s: IA simbólica, sistemas expertos, lenguaje LISP. Mucho entusiasmo… pero poco poder de cómputo.

-

1980s: renace la IA con sistemas expertos (como XCON) en empresas.

-

1990s: aparece el Machine Learning (aprendizaje automático).

-

1997: Deep Blue (IBM) vence a Kasparov (1997) al ajedrez.

-

2000s: Se populariza el data mining y los algoritmos más eficientes.

-

2010s-2020s: Explosión del Deep Learning, redes neuronales profundas, asistentes virtuales, IA generativa (como ChatGPT, Midjourney, etc.).

- 2016 La IA gana en el juego GO aplicando intuición humana simulando a nuestras redes neuronales de pensamiento profundo.

Mientras la CPU procesa programas y cálculos, la GPU procesa gráficos

+ info: https://datademia.es/blog/que-son-la-cpu-y-gpu

¿Cómo se hace la Inteligencia Artificial?

Para «hacer» IA necesitas un equipo mínimo de procesador que puedes encontrar en cualquier ordenador del mercado, conectandote a la nube de Google Colab que es gratis si no tienes GPU.

⚡ Comparativa rápida

| Tipo de IA | Hardware recomendado | Coste aproximado |

|---|---|---|

| IA básica (CPU) | Laptop con 16GB RAM | 600–1.000 € |

| DL intermedio | PC con RTX 3060 + 32GB RAM | 1.500–2.500 € |

| IA profesional | Multi-GPU (RTX 4090 x2) | 5.000 €+ |

| IA en la nube | Google Colab / AWS (pago por uso) | 0.5–5 €/hora |

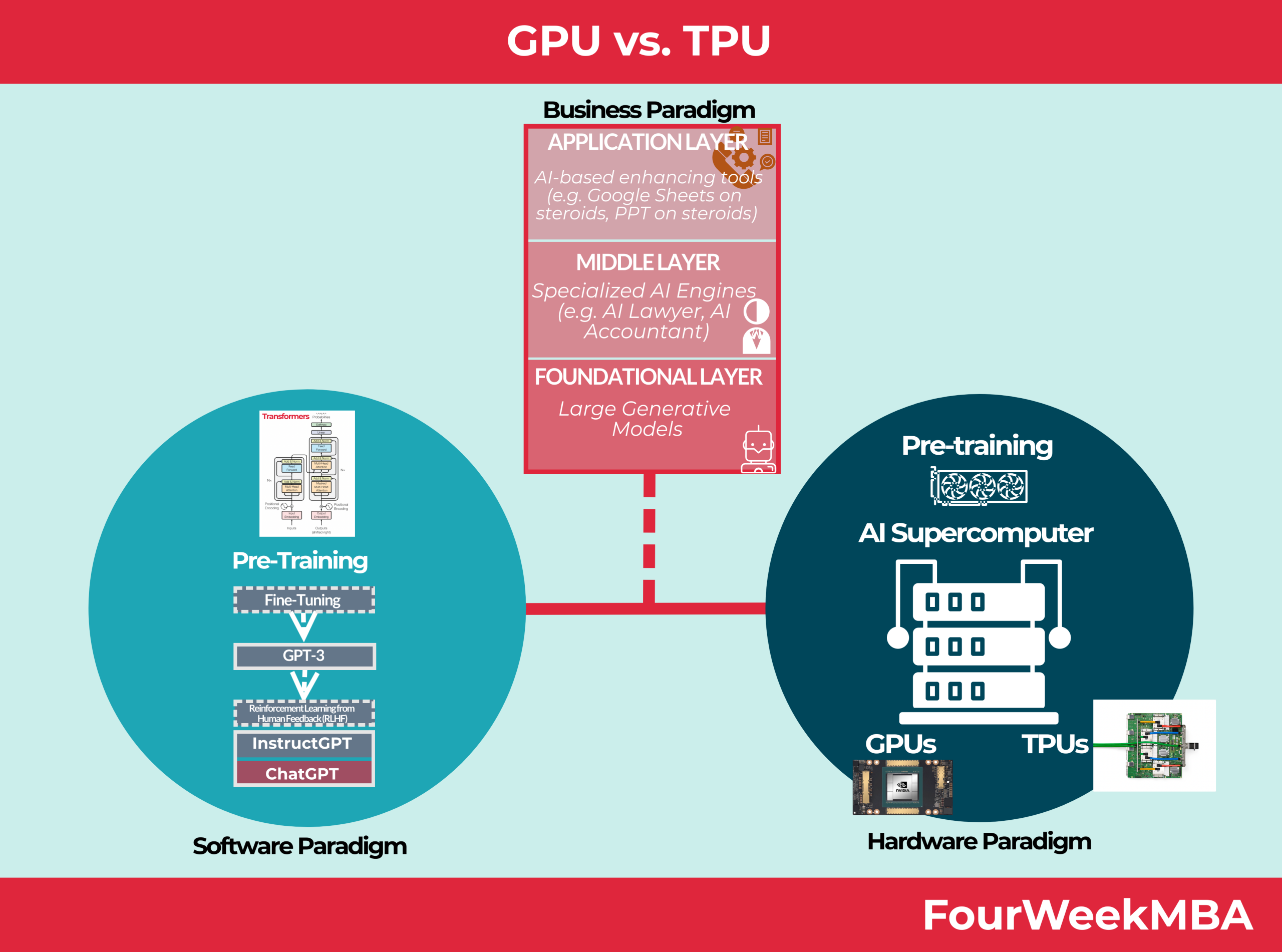

La máquina que hace IA se compone a nivel de maquinaria (hardware) de un ordenador CPU / GPU / TPU donde instalaremos el sistema operativo y los programas (software) para procesamiento rápido de datos y cálculos, modelos informáticos que intentan reproducir el pensamiento neuronal humano.

- CPU: Unidad central de procesamiento, solo para IA muy básica (ej.: chatbots pequeños).

✅ Para qué sirve: Ejecuta instrucciones generales (sistema operativo, apps, cálculos simples).

🔹 Arquitectura: Pocos núcleos (4–32), pero muy versátiles.

⚡ Consumo: Moderado (15W–150W).

💡 Ventaja: Multitarea eficiente, baja latencia.

⚠ Desventaja: Lento para cálculos masivos en paralelo (como IA).

📌 Ejemplo: Intel Core i9, AMD Ryzen.

- GPU: Unidad de procesamiento gráfico, ideal para entrenar modelos (NVIDIA es líder con CUDA).

✅ Para qué sirve: era para generar gráficos, ahora clave en IA y minería de criptomonedas.

🔹 Arquitectura: Miles de núcleos pequeños (ej: NVIDIA RTX 4090 → 16,384 núcleos CUDA).

⚡ Consumo: Alto (250W–500W).

💡 Ventaja: Acelera cálculos paralelos (entrenamiento de IA, renderizado 3D).

⚠ Desventaja: Menos eficiente que las TPU para IA pura.

📌 Ejemplo: NVIDIA RTX 4090, AMD Radeon RX 7900 XT.

+ info: https://fourweekmba.com/es/gpu-contra-tpu/

- TPU: La mejor para inferencia a gran escala (Google Cloud, servicios como Gemini).

✅ Para qué sirve: Diseñada exclusivamente para IA (Google Brain).

🔹 Arquitectura: Optimizada para operaciones matriciales (álgebra lineal, redes neuronales).

⚡ Consumo: Muy eficiente (menos Watts por operación que GPU).

💡 Ventaja: Hasta 30x más rápida que GPUs en inferencia de IA.

⚠ Desventaja: Solo útil para IA, no para gráficos o tareas generales.

📌 Ejemplo: Google TPU v4 (usado en Gemini, ChatGPT competidores).

Estas máquinas suelen estar en remoto y accedes a ellas vía online, usando la “nube”.

¿Cuánta energía necesita la Inteligencia Artificial?

Estas máquinas están ubicadas en grandes centros de datos; cuando usas ChatGPT, Midjourney, Gemini o similares, estás enviando tu solicitud a un servidor remoto, tú solo ves el resultado en tu pantalla.

Centro de datos de Harbin China, está diseñado para integrarse completamente entre el paisaje natural y para ser cada vez más eficiente.

Con una superficie más de dos millones de metros cuadrados, la instalación, propiedad y operada por China Mobile, es una de las operaciones emblemáticas de la empresa. Harbin consume 150 megavatios de electricidad.

Centro de datos de Kolos, Noruega

El centro de datos más grande de Europa se encuentra en un pequeño pueblo de Noruega, se llama Kolos, cubre dos millones de metros cuadrados en cuatro plantas y se posiciona como un centro de datos hiperescalable, con planes de consumir hasta 1000 megavatios de energía para 2027. Una de sus principales características es que está perfecta y estéticamente integrado en el paisaje natural. Kolos, una empresa estadounidense-noruega, insiste en que la instalación funcionará al 100% con fuentes de energía renovables, aprovechando la abundante infraestructura hidroeléctrica de Noruega. Según la empresa, esto genera un ahorro del 60% en los costos de energía, lo que reduce aún más los precios para el consumidor.

+ info: https://www.xataka.com/pro/asi-cinco-cpds-grandes-mundo

- Centro de datos de Telecomunicaciones de China.

- Centro de datos de Kolos, Noruega.

- Centro de datos de Harbin, China.

- The Citadel, Estados Unidos.

- Range International Information Group, China.

- Switch SuperNAP, Las Vegas.

- Centro de datos de Utah.

- Centro de datos de Microsoft, Iowa.

¿Y si yo quiero entrenar una IA?

Para hacer Inteligencia Artificial solo necesitas tener un problema y querer buscar y encontrar una solución.

Tienes 2 opciones:

Local (en tu PC)

Usas tu CPU y/o GPU si son potentes (como una tarjeta NVIDIA).

- Instalas Visual Code Studio

Ideal para modelos pequeños o experimentos, por ejemplo hacer una aplicación estilo Netflix, un alquiler de películas online, una tienda online, etc.

En la nube

- Usas servicios como Google Colab, AWS, Azure, o Paperspace, que tienen GPU o TPU listas para usar.

Ideal para proyectos grandes o modelos pesados.

¿Cuánto consume usar IA?

- Hay un consumo constante de energía, aunque la gente no utilice las aplicaciones, chats con IA, etc. Se puede comparar fácilmente con una nevera, que está todo el día encendida y consume lo mismo, aunque la tengas vacía o llena, la abras o la cierres.

- Cuando contabilizamos el consumo de energía para hacer presupuestos y valoraciones a nivel profesional, no se tiene en cuenta el gasto unitario de una persona haciendo una ilustración al estilo Studio Ghibli, sino que cuenta todo lo que usa el ChatGPT en 1 año a nivel global, y se contabiliza como gasto constante unitario. Aunque la necesidad de energía para utilizar la IA aumenta en relación con la cantidad de usuarios que utilizan la aplicación a la vez, se cuenta la energía utilizada en conjunto.

Ejemplo imagen hecha con Chat GPT estilo anime del Studio Ghibli consume como 3 sorbos de agua de una botella de 500ml.

¿Se puede reducir este gasto?

Las empresas están trabajando en:

- «Serverless IA»: Apagar servidores cuando no hay demanda (ya lo hacen en parte con escalado automático).

- Hardware eficiente: Chips como los TPUs de Google o los GPUs con tensor cores reducen el consumo en reposo.

- Energías renovables: Google/Microsoft usan energía solar/eólica para compensar.

Sí, las IA consumen energía aunque no las uses, pero la mayor parte del gasto está en la infraestructura (centros de datos) y no en los modelos específicos. El impacto real depende de cómo las empresas gestionen sus recursos.

En comparación con una nevera doméstica ¿cómo sería el gasto energético de la IA?

🔍 Comparación de consumo energético

Nevera doméstica (típica)

- Consumo promedio: 100–200 kWh/año (dependiendo de la eficiencia).

- Potencia en funcionamiento: 100–300W (pero no está siempre encendida, ya que activa/desactiva el compresor).

- Consumo diario aproximado: 0.5–1.5 kWh (unos 30–50W de promedio constante).

IA en la nube (servidores)

- Por consulta (ej.: ChatGPT): 0.001–0.01 kWh (equivalente a 1–10W durante unos segundos).

- Servidor inactivo (solo por existir): 100–300W (similar a una nevera funcionando).

- Centro de datos completo: Megavatios (MW) a Gigavatios (GW) (miles de neveras funcionando a la vez).

IA local (ej.: Stable Diffusion en tu PC)

- Generar 1 imagen: ~0.05–0.1 kWh (como tener una nevera encendida 20–60 minutos).

- Entrenar un modelo pequeño: 10–50 kWh (equivalente a 1–2 meses de nevera).

📊 Tabla comparativa (aproximada)

| Dispositivo/Tarea | Consumo típico | Equivalente en tiempo de nevera |

|---|---|---|

| 1 consulta en ChatGPT | 0.001–0.01 kWh | 30 segundos – 5 minutos |

| 1 imagen en Midjourney | ~0.01 kWh | 5–10 minutos |

| 1 servidor inactivo | 100–300W (constante) | 1 nevera funcionando |

| 1 centro de datos pequeño | 1 MW (1,000,000W) | 5,000–10,000 neveras |

| Entrenar GPT-3 | 1,300 MWh (≈1,300,000 kWh) | 6,500 años de nevera 🚀 |

Usar IA ocasionalmente (como hacer preguntas en ChatGPT) gasta mucho menos que una nevera.

Pero los servidores que la mantienen viva consumen como miles de neveras siempre encendidas.

Generar imágenes/vídeos o entrenar modelos es donde el gasto se dispara (equivalente a meses o años de nevera).

¿Es sostenible usar la IA?

Depende: si las empresas usan energías renovables y optimizan hardware, el impacto puede reducirse. Pero hoy, un centro de datos de IA grande gasta como una ciudad pequeña.

Vamos a calcular el gasto energético de la IA en términos de botellas de agua, usando como referencia la energía necesaria para producir, transportar y reciclar una botella de plástico.

Datos clave para la comparación

Energía para producir 1 botella de plástico (500ml):

≈ 0.2 – 0.3 kWh (incluye fabricación, transporte y gestión de residuos)[*].

Consumo de IA por tarea:

- 1 consulta en ChatGPT ≈ 0.001 – 0.01 kWh.

- 1 imagen con Stable Diffusion ≈ 0.05 – 0.1 kWh.

- Entrenar GPT-3 ≈ 1,300,000 kWh (como 5 millones de botellas).

Comparación práctica

| Tarea de IA | Energía consumida (kWh) | Equivalente en botellas de agua (500ml) |

|---|---|---|

| 1 pregunta a ChatGPT | 0.001 – 0.01 kWh | 0.003 – 0.05 botellas (¡menos que una!) |

| 1 imagen en Midjourney | 0.01 – 0.1 kWh | 0.05 – 0.5 botellas |

| 1 hora usando IA en tu PC | 0.1 – 0.5 kWh | 0.5 – 2 botellas |

| Entrenar GPT-3 | 1,300,000 kWh | 5,000,000 botellas (¡llenar 2 piscinas olímpicas!) |

- Usar IA para tareas pequeñas (chatear, generar imágenes) gasta menos energía que producir una botella de agua.

- Pero entrenar modelos grandes (como GPT-4 o Gemini) consume tanto como millones de botellas.

- La huella ecológica de la IA depende mucho del uso:

- Uso responsable (consultas esporádicas) = impacto mínimo.

- ⚠ Entrenar modelos desde cero = impacto enorme (similar a la industria del plástico).

El futuro de la IA es personalizarlo todo y ser eficiente

- Hiperpersonalización: Modelos que se adapten a tu voz, estilo y necesidades en tiempo real.

- Eficiencia extrema: Chips neuromórficos y algoritmos ligeros (como DeepSeek-V3) que consuman 10x menos energía.

- IA en el dispositivo: Sin depender de la nube (ej.: ChatGPT en tu móvil offline).

- Autonomía con sentido común: Robots que aprendan de pocos ejemplos, como humanos.

- Ética integrada: Sistemas que expliquen sus decisiones y eviten sesgos por diseño.

🚀 Menos gasto, más precisión y IA que te entienda realmente.

Ejemplo de imagen creada con Chat GPT sobre un promt de una muñeca de mi propia persona como prototipo para juguete personalizado con mi mochila de gato negro, iphone y libreta de ideas.

El futuro de la IA es hacer cosas personalizadas como series, películas, imagínate viendo una serie de Netflix y en medio del capítulo decirle a una IA que cambie la trama como a ti te gustaría.

Así que lo normal es y será que cada persona que quiera pueda acceder para hacer a su estilo todo lo que le apetezca: videojuegos, música, cine, humor, cursos, todo tipo de productos y servicios.

¿Por qué personalizar tanto?

La palabra más buscada en Google es Regalos originales y una de las siguientes de la lista es Regalos personalizados, porque la gente no sabe ya qué regalar cuando lo tenemos casi todo, incluso regalos a una misma, viajes, cenas, masajes, spa’s, clases particulares de pintura, de arte, rutas personalizadas por museos, ciudades, etc; experiencias convertidas en algo especial para alguien.

¿Qué supone Deep Seek como revolución dentro de la IA?

DeepSeek representa una revolución en el campo de la IA por varias razones clave, destacando en eficiencia, capacidades avanzadas y accesibilidad. Aquí te explico por qué es un avance significativo:

Modelos de lenguaje más potentes y eficientes

- DeepSeek-V3 (su modelo más reciente) compite con GPT-4 y Gemini 1.5, pero con un enfoque en menor consumo computacional.

- Soporta un contexto de 128K tokens, lo que permite analizar documentos largos (libros, informes técnicos) sin perder coherencia.

- Optimizado para razonamiento matemático y código, superando a muchos modelos en tareas técnicas.

Enfoque multilingüe avanzado

- Está especialmente diseñado para alto rendimiento en español, chino e inglés, reduciendo la brecha con los modelos anglodominantes (como GPT-4).

- Traducción de alta calidad y comprensión contextual en idiomas no mayoritarios.

Accesibilidad y open-source

- DeepSeek publicó versiones abiertas de sus modelos (ej.: DeepSeek-Coder para programación), democratizando el acceso a IA avanzada.

- Ofrece APIs competitivas en precio, retando a OpenAI y Google en coste-rendimiento.

Especialización en búsqueda y razonamiento

- Integración con motores de búsqueda: Puede recuperar información en tiempo real (como Perplexity.ai), combinando generación con datos actualizados.

- Excelente en lógica y matemáticas: Supera a GPT-4 en benchmarks como MATH y GSM8K (problemas matemáticos complejos).

Optimización para empresas e investigación

- Menor coste computacional: Entrenado con técnicas de eficiencia energética, clave para reducir huella ambiental.

- Aplicaciones en ciencia y finanzas: Desde análisis de datos hasta generación de informes técnicos precisos.

Comparación con otros modelos

| Característica | DeepSeek-V3 | GPT-4 | Gemini 1.5 |

|---|---|---|---|

| Contexto máximo | 128K tokens | 128K | 1M tokens |

| Multilingüe | ✅ (Español/Chino fuerte) | ✅ (Sesgo inglés) | ✅ (Google Translate) |

| Open-source | Parcial (algunos modelos) | ❌ | ❌ |

| Costo inferencia | Más económico | Alto | Medio |

¿Por qué es revolucionario Deep Seek?

- Combina altas capacidades con eficiencia, algo crítico para aplicaciones reales.

- Prioriza lenguas no inglesas, rompiendo el monopolio angloparlante en IA.

- Su enfoque «búsqueda + generación» lo hace ideal para usos profesionales (investigación, desarrollo).

Si antes las opciones eran «GPT-4 o nada», ahora DeepSeek ofrece una alternativa potente, más accesible y especializada.

La promesa de grandes beneficios para las empresas del sector por el desarrollo de la Inteligencia Artificial ha generado muy buenos resultados en bolsa en los últimos meses, con el auge de compañías como Nvidia, que en 2024 llegó a ser la empresa más grande del planeta, pero ahora está cayendo gracias a la política arancelaria de Trump.

Así se evidencia también que la guerra es sobre las tierras raras porque todo lo que hace EEUU a nivel tecnológico necesita para existir y todas están en China por el momento.

¿Cómo reducir el impacto?

- Usar modelos eficientes (ej.: Llama 3 vs. GPT-4).

- Reciclar hardware y usar energías renovables.

- Evitar generar contenido innecesario (ej.: imágenes que no se usan).

También hay que tener en cuenta que gracias a estos avances podremos conseguir hitos como curar el cáncer, ayudar a democratizar la educación haciendo accesible toda la información para todo el mundo, hacer más eficiente el consumo y la fabricación de todo, etc.

Otras IA que están surgiendo modelo open source…

LLama https://www.lama.ai/

LLaMA (Large Language Model Meta AI), el modelo de lenguaje de Meta (Facebook).

🦙 ¿Qué es LLaMA?

- Modelo de IA open-source desarrollado por Meta, competidor directo de GPT (OpenAI) y Gemini (Google).

- Versiones: LLaMA-1 (2023) y LLaMA-2 (2023), con tamaños desde 7B hasta 70B parámetros.

- Open-weight: Puede descargarse y ejecutarse localmente (a diferencia de ChatGPT).

¿Por qué es revolucionario?

Accesibilidad:

-

- Funciona en hardware modesto (una RTX 3090 puede ejecutar LLaMA-7B).

- Alternativas optimizadas: Alpaca, Vicuna, Llama.cpp (para CPU).

Enfoque ético:

- Meta evitó entrenarlo con datos privados de usuarios (a diferencia de GPT).

- Comunidad activa:

- Miles de desarrolladores han creado fine-tunings especializados (ej.: medicina, derecho).

LLaMA-2 vs. GPT-4

| Característica | LLaMA-2 | GPT-4 |

|---|---|---|

| Open-source | ✅ (pesos públicos) | ❌ |

| Hardware | GPU/CPU local | Solo en la nube |

| Rendimiento | Similar a GPT-3.5 | Más potente |

| Idiomas | Multilingüe (énfasis EN) | Multilingüe avanzado |

Usos prácticos de LLaMA

- Chatbots locales (sin depender de APIs).

- Investigación en IA (modificar el modelo libremente).

- Aplicaciones especializadas (ej.: finetuning para código con WizardCoder).

Limitaciones

- Requiere técnicidad (instalarlo no es como usar ChatGPT).

- Menos pulido que modelos comerciales en conversación.

¿Quieres probarlo? Te recomiendo:

- LM Studio (para Windows/macOS fácil).

- Ollama (para Linux/macOS con terminal).

Para usar LLaMA (el modelo de lenguaje de Meta) eficientemente, el hardware requerido depende de la versión del modelo (7B, 13B, 30B, 65B) y si lo ejecutas localmente o en la nube. Aquí tienes una guía detallada:

Equipo para LLaMA-2 (versiones más usadas: 7B y 13B)

Mínimo viable (inferencia básica):

- CPU: Intel/AMD con soporte AVX2 (ej.: Intel i5 8ª gen+ o Ryzen 5 3000+).

- RAM: 16GB (para 7B) / 32GB (para 13B).

- Almacenamiento: SSD (el modelo 7B ocupa ~4GB en 4-bit).

- Sin GPU: Usando llama.cpp (optimizado para CPU).

Recomendado (para fluidez):

- GPU: NVIDIA con 8GB+ VRAM (RTX 3060/3080 para 7B/13B en 8-bit).

- RAM: 32GB+ (para evitar cuellos de botella).

- Software:

- Ollama (sencillo, automático).

- Text Generation WebUI (interfaz amigable).

Equipo para LLaMA-2 30B/65B (o fine-tuning)

- GPU: NVIDIA A100 40GB o 2x RTX 4090 (24GB cada una).

- RAM: 64GB+ (para 65B, incluso 128GB).

- Alternativa: Alquilar instancias en la nube (Lambda Labs, RunPod).

📌 Resumen por versión

| Modelo | RAM Mínima | GPU Recomendada | Notas |

|---|---|---|---|

| LLaMA-7B | 16GB | RTX 3060 (8GB) | Funciona hasta en CPU. |

| LLaMA-13B | 32GB | RTX 3080 (12GB) | 8-bit con GPU fluido. |

| LLaMA-30B | 64GB | 2x RTX 3090 (24GB) | Requiere quantización (4-bit). |

| LLaMA-65B | 128GB+ | A100 80GB | Solo viable en la nube. |

Optimizaciones clave

- Quantización: Reducir precisión (ej.: 4-bit) para ahorrar memoria. Herramientas:

- GGUF (para CPU/GPU ligera).

- AWQ (para NVIDIA GPUs).

- Formatos eficientes:

- llama.cpp (CPU/Apple Silicon).

- TensorRT-LLM (máximo rendimiento en NVIDIA).

Opción en la nube (sin hardware potente)

- Servicios:

- Google Colab Pro (T4 o V100 gratis, A100 de pago).

- RunPod ($0.79/hora por una RTX 4090).

- Ventaja: Sin instalar nada; acceso inmediato a LLaMA-70B.

Consejos prácticos

- Para probar rápido: Usa LM Studio (Windows/macOS) con modelos pre-cuantizados.

- Si tienes Mac: Los chips M1/M2/M3 ejecutan LLaMA-7B/13B muy bien via llama.cpp.

- Evita overheating: En laptops, limita tokens/sec con

--threads 4(CPU).

[*] Fuentes:

Estudios sobre ciclo de vida del plástico (EPA, Universidad de California).

IA Y TRANSICIÓN ECOSOCIAL JUSTA

Video de la presentación «IA y cambio global»

Un diálogo donde Pere Brunet, autor de «IA y Cambio Global», conversa con Lucía Ortíz de Zárate, investigadora en ética y Gobernanza de la IA de la Universidad Autónoma de Madrid.

Una maravillosa oportunidad para aproximarse de forma amena y didáctica a los debates y dilemas que plantea el desarrollo de esta nueva tecnología.

Ver video: AQUÍ

Accede al informe: AQUÍ

Geoestrategia juego GO China, Japón, Taiwán, Corea, etc.

Dicen que es la fórmula que siguen los estrategas comerciales del mundo asiático.